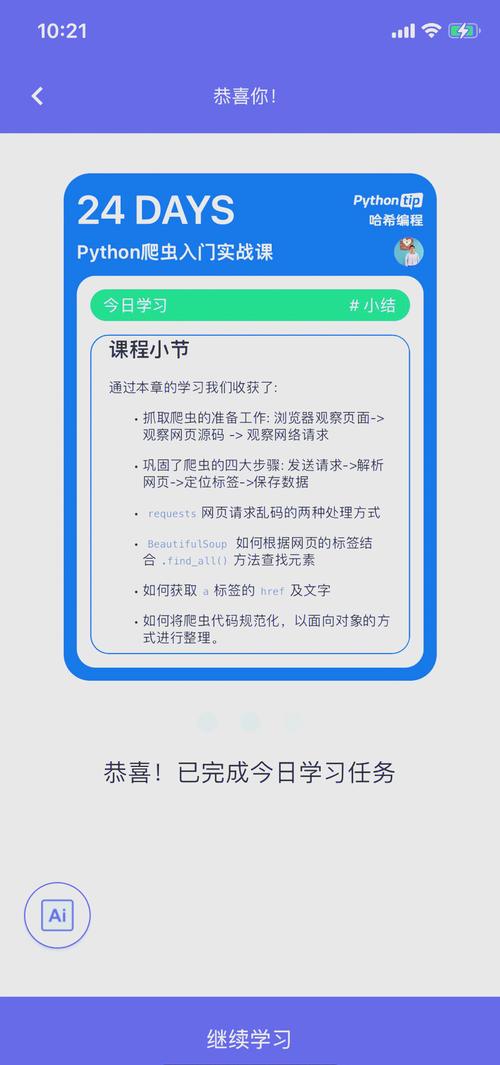

使用爬APP的软件高效获取数据的方法与实践

在现代信息技术快速发展的背景下,爬取APP数据已经成为了一个热门话题。对于我来说,爬取数据的过程像是一场探索之旅,每一次的探索都能让我获得新的见解和收获。简单地说,爬取APP数据就是通过一系列的技术手段,自动获取应用程序内的数据,包括文字、图像,以及其他我所需的信息。这一过程往往涉及抓取数据、分析结构和存储信息,让我能够在海量数据中提炼出有价值的内容。

数据爬取的意义远不止于获取信息。对我而言,能够分析用户行为、市场趋势和竞争对手的动态,都是帮助我在决策中更具优势的重要因素。特别是在商业行业,通过对用户反馈和使用习惯的深入分析,可以让我更好地理解客户需求,进而优化产品和服务。此外,爬取数据也有助于商业情报的收集,不论是在学术研究还是行业分析领域,这都是促进创新和推动发展的重要步骤。

在进行APP数据爬取之前,需要认真考虑法律和伦理问题。对我而言,数据的合法性和伦理性十分重要。在一些国家与地区,关于数据隐私的法律如GDPR已经做出了严格规定。遵循法律法规,不仅是我作为开发者的责任,同时也是对用户的尊重。为此,我常常会仔细研究相关法律,并确保我的数据爬取过程遵循相应的道德标准,保护用户的隐私权与数据安全。这种心态不仅能让我避免法律风险,更能赢得用户的信任与支持。

通过对爬取APP数据的理解,我认识到这不仅是一个技术问题,更是一个涉及法律、伦理以及商业智能的多维话题。在未来的章节中,我将进一步探讨具体的方法、工具和最佳实践,帮助我更有效地进行数据爬取。

在开始实际的爬取工作之前,我发现了解不同的数据爬取方法至关重要。每种方法都有其独特的优缺点,适用于不同的场景。我将从API爬取、UI自动化测试工具和数据包嗅探技术等几个方面进行详细介绍。

API爬取方法

使用API进行数据爬取是一个比较常见且高效的方式。许多应用程序或平台都会提供官方API,允许我按照其规定安全地获取数据。当我使用官方API时,通常能获得结构化的数据,这对数据的分析和处理大有帮助。通过请求API接口,我可以轻松获取用户信息、产品列表、评论内容等,而这些都是通过其他方式难以获取的。此外,官方API的使用往往会伴随良好的文档支持,能帮助我更快上手。

然而,使用第三方API时需要提高警惕,尤其是当这些API的合法性和数据质量不够明确时。在接入第三方API时,我会仔细阅读相关条款,确保采用的数据不会侵犯其他用户的隐私权或知识产权。总之,选择合适的API,不仅关乎数据的有效性,还直接影响到我后续的工作效率。

UI自动化测试工具

其次是UI自动化测试工具,它为爬取数据提供了另一种选择。这类工具可以模拟用户在APP中的操作,通过点击、滑动等方式来获取数据。我之前常用的工具包括Selenium和Appium等。特别是当面对那些没有开放API的应用时,UI自动化测试工具展现了其独特的魅力。通过简单的配置,我就能快速编写爬虫脚本,进行自动化操作,获取所需信息。

设置这些工具的过程虽然可能会有些繁琐,但通常会有很多社区支持和示例代码供我参考。掌握这些工具并熟悉其配置,能让我在爬取数据时变得更加得心应手。尽管相较于API爬取,这种方法可能会稍显缓慢,但它的灵活性正好弥补了这一不足。

数据包嗅探技术

最后,数据包嗅探技术是爬取APP数据的另一种方法。这一过程涉及使用网络嗅探工具,如Wireshark或Fiddler,监测应用程序之间的网络数据传输。我发现,这种方式能够深入了解应用如何与服务器交互,同时也能分析数据请求和响应格式,帮助我更好地理解需要抓取的数据。

面对HTTPS流量时,数据的传输更为安全,因此需要额外的技巧来解析数据。通过设置证书和配置代理,我能顺利访问加密流量。这使得我能够解码HTTPS请求,获取实际的数据请求信息。虽然这项技术对初学者来说可能会有一些难度,但深入掌握后,能够让我在数据爬取的灵活性和深度上实现更大的突破。

在探讨各类爬取方法的过程中,我逐渐认识到不会存在“放之四海而皆准”的最佳解决方案。选择哪种爬取方法,往往取决于具体的需求,以及数据的访问权限。在下一章节中,我将逐步介绍更具体的工具,让我在爬取数据时拥有更多的选择和策略。

在了解了各种爬取方法之后,下一步就是选择合适的工具来实现数据爬取。工具的选择直接影响到爬取的效率、准确性和可维护性。我将从常见的爬虫工具和特定平台的工具两方面进行探讨。

常见爬虫工具介绍

首先是一些流行的爬虫工具。Selenium 是我最常用的工具之一,它以其强大的功能和灵活性广受开发者欢迎。使用 Selenium,我可以模拟实际用户在浏览器中进行的各种操作,比如点击按钮、填写表单以及滚动页面等。它支持多种编程语言,让我可以根据自己的需要进行选择。通过使用 Selenium,我得以访问动态加载的数据,获取那些在普通HTTP请求中无法直接抓取的信息,真的是一款强大的工具。

另一个让我非常欣赏的爬虫框架是 Scrapy。这个框架专为爬取大量数据而设计,非常适合处理复杂的网站。我之前在一些项目中使用过 Scrapy,它允许我通过简单的命令行操作快速构建爬虫,灵活定义爬取规则。不但能高效地进行抓取,还提供了完善的数据处理功能,能够直接将抓取的数据存储到不同的数据库中。Scrapy 还支持并发请求,这让我在抓取大批量数据时性能表现出色。

特定平台的工具推荐

除了上述通用工具,有时特定平台的工具会更有效率。对于 Android 应用数据爬取,我发现使用 Appium 非常方便。这个工具专为移动应用开发,能够帮助我直接与 Android 应用进行交互,获取所需的信息。Appium 的优点在于它的跨平台性质,支持不同类型的移动设备,让我的爬取工作不再局限于某一种设备。

而对于 iOS 应用,使用 XCUITest 是一个不错的选择。通用的 UI 自动化框架相比,它提供了更好的性能和集成支持。通过 XCUITest,我能够更轻松地与 iOS 应用进行交互,尤其是在处理复杂的手势和响应时表现得尤为出色。这让我在数据爬取方面有了更大的灵活性。

选择合适的工具并不是一蹴而就的过程。需要根据实际需求和目标应用的特性,评估每种工具的优缺点。在不断试验和使用中,我逐渐摸索出最适合我的那一款。总之,利用合适的爬虫工具,将极大提高我的数据爬取效率和成果的准确性。如同了解了不同的方法,选择合适的工具也是我进行数据爬取的关键一步。在后续的章节中,我会深入探讨一些最佳实践,让我在实际工作中更加得心应手。

在开始爬取数据之前,我意识到一些技巧和最佳实践能够显著提升我的工作效率和成功率。特别是在应对复杂的反爬虫机制和进行数据清洗与处理时,掌握这些实用技巧尤为重要。

反爬虫技术的应对策略

首先,了解常见的反爬虫机制至关重要。我发现,大多数APP会采取不同程度的反爬虫策略,比如限制请求频率、使用验证码以及监控访问模式等。为了应对这些挑战,我通常会调整我的爬取策略。例如,增加请求间隔时间,可以有效降低被识别为爬虫的风险。同时,我会随机更改请求头信息,这样能更像一个真实用户从而避免被封锁。

代理的使用也是一个不错的选择。通过使用繁多的代理服务器,我能够分散我的请求,从而降低对单一IP的压力。我通常会管理一个代理池,以便在需要时快速切换,不仅保护了我的IP地址,还提升了爬取的稳定性。可以选择一些专业的代理服务,提供多种IP地址供我使用。这样,我在爬取数据时更加游刃有余,不再担心被反爬虫机制阻挡。

数据清洗与处理

爬取到的数据往往是“脏数据”,因此数据清洗与处理十分必要。在这个过程中,我会去除重复条目、修正错误信息以及处理缺失数据等操作。为了省去手动清洗的时间,我会使用一些数据处理工具,如 Pandas。这是一个强大的数据分析库,通过简单的操作,就能完成复杂的数据清理工作。

选择合适的工具也至关重要。对于项目的不同需要,我会根据数据的特性选择合适的数据处理方案,比如如果数据量较大,就可能需要采用更高效的算法来处理。同时,数据的完整性与准确性也会直接影响后续分析与使用的效果。因此,在数据处理的过程中,我会时刻保持一份严谨,确保每一份数据都能通过我设定的标准。

通过这些技巧与策略的运用,我获得了更多的成功经验。在爬取APP数据时,不仅要掌握技术,更要灵活应对各种变化。未来在数据爬取的道路上,我将不断探索和完善这些最佳实践,让我的工作更加顺利和高效。

在进行APP数据爬取的过程中,案例分析往往能够提供深刻的洞察和实用的经验。我在这段时间收集了一些成功的爬取案例,每一个都能带给我新的学习和启发。

成功的APP数据爬取案例分享

让我印象深刻的是一次针对某流行社交APP的爬取项目。我们的目标是获取用户的评论数据,以便进行情感分析和趋势预测。在这个过程中,我采用了API爬取方法,首先申请了该APP的官方API,虽然有些数据不全,但操作起来相对简单。此外,我还利用了多种爬虫工具,结合了Selenium来模拟用户的实际操作,从而绕开了部分反爬虫限制。最终,我们成功获取了所需数据,分析结果也帮助我们客户获得了市场战略的洞察。

还有一个案例是针对某电商平台的价格监控。为了实时跟踪商品价格变动,我决定使用数据包嗅探技术。通过设置网络嗅探工具,我观察到了APP的请求与响应,并从中提取了商品的价格信息。这项技术对我而言充满挑战,但成功实施后,显著提升了我们的产品决策效率。

常见问题与解决方案

在爬取APP数据的过程中,确实会遇到各类问题。其中,最常见的就是数据不一致和反爬虫机制。比如,在一个项目中,由于API的更新,原本可以顺利使用的接口突然失效,导致部分数据无法获取。为了解决这个问题,我主动联系了技术支持,同时研究API文档,快速找到备用接口,并调整了我们的数据获取策略。

另一个常见的问题是被封禁IP的风险。为了应对这种情况,我在爬取之前会提前测试请求频率和时长。通过合理分配请求时间,我通常能降低被封禁的机会。此外,我逐步建立了一个稳定的代理池,这样即便某个IP被封禁,我也能快速切换到其他可用的IP。

总结与未来展望

通过这些案例和经验的总结,我认识到成功进行APP数据爬取的关键在于持久的探索和灵活的应对能力。未来,我希望能够更深入地研究反爬虫机制及其解决途径。技术的快速发展让我意识到,学习永无止境,尤其是在数据领域,我要不断更新自己的技能,优化现有流程。

展望未来,爬取APP数据的应用场景将不断扩展,新的技术和工具将不断涌现。保持对行业动态的关注,并融入更多的创新思维,才能在这个快速变化的环境中立于不败之地。我期待与大家共同探索这片充满机遇的领域。