您现在的位置是:首页 > tp钱包app安卓版下载 > 正文

tp钱包app安卓版下载

tokenize的中文-tokenisempty中文

nonunique的中文翻译是非唯一重点词汇unique词语分析音标英ju#712ni#720k美ju#712ni#720kadj唯一的,独一无二的独特的,稀罕的n独一无二的人或物

non unique的中文翻译是非唯一 重点词汇unique 词语分析音标英 ju#712ni#720k 美 ju#712ni#720kadj 唯一的,独一无二的独特的,稀罕的 n 独一无二的人或物 短语unique skill。

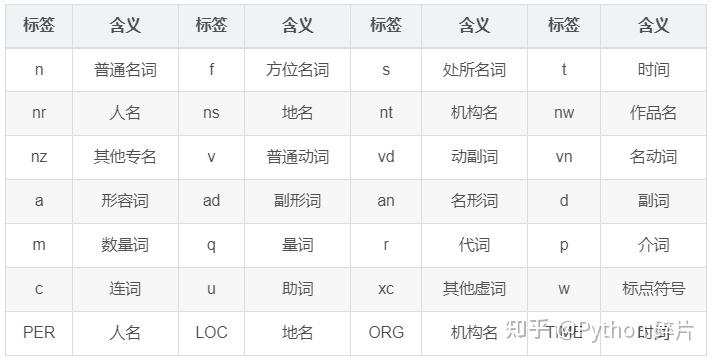

jieba是一个在中文自然语言处理中用的最多的工具包之一,它以分词起家,目前已经能够实现包括分词词性标注以及命名实体识别等多种功能既然Jieba是以分词起家,我们自然要首先学习Jieba的中文分词功能Jieba提供了三种分词模式。

公式的分母是统计在参考译文中Ngram的个数,而分子是统计参考译文与机器译文共有的Ngram个数对两个生成句和参考句word piece进行tokenize分别用bert提取特征,然后对2个句子的每一个词分别计算内积,可以得到一个相。

用到的函数nltksent_tokenizetext #对文本按照句子进行分割 nltkword_tokenizesent #对句子进行分词 二NLTK进行词性标注 用到的函数nltkpos_tagtokens#tokens是句子分词后的结果,同样是句子级的标注 三。

一NLTK进行分词 用到的函数nltksent_tokenizetext #对文本按照句子进行分割 nltkword_tokenizesent #对句子进行分词 二NLTK进行词性标注 用到的函数nltkpos_tagtokens#tokens是句子分词后的结果,同样是。