TP钱包官网下载最新版本2024

encoderdecoder架构-encoder decoder架构

很明显,这个问题直接可以由EncoderDecoder框架来进行下联自动生成这种场景是典型的EncoderDecoder框架应用问题我们所需要做的就是配置好EncoderDecoder框架的具体模型,比如Encoder和Decoder都采用RNN模型来做,图2展示了用EncoderDecoder框架做对联下联自动生成的架构图图2 EncoderDecoder生成下联只需要找到大量的对。

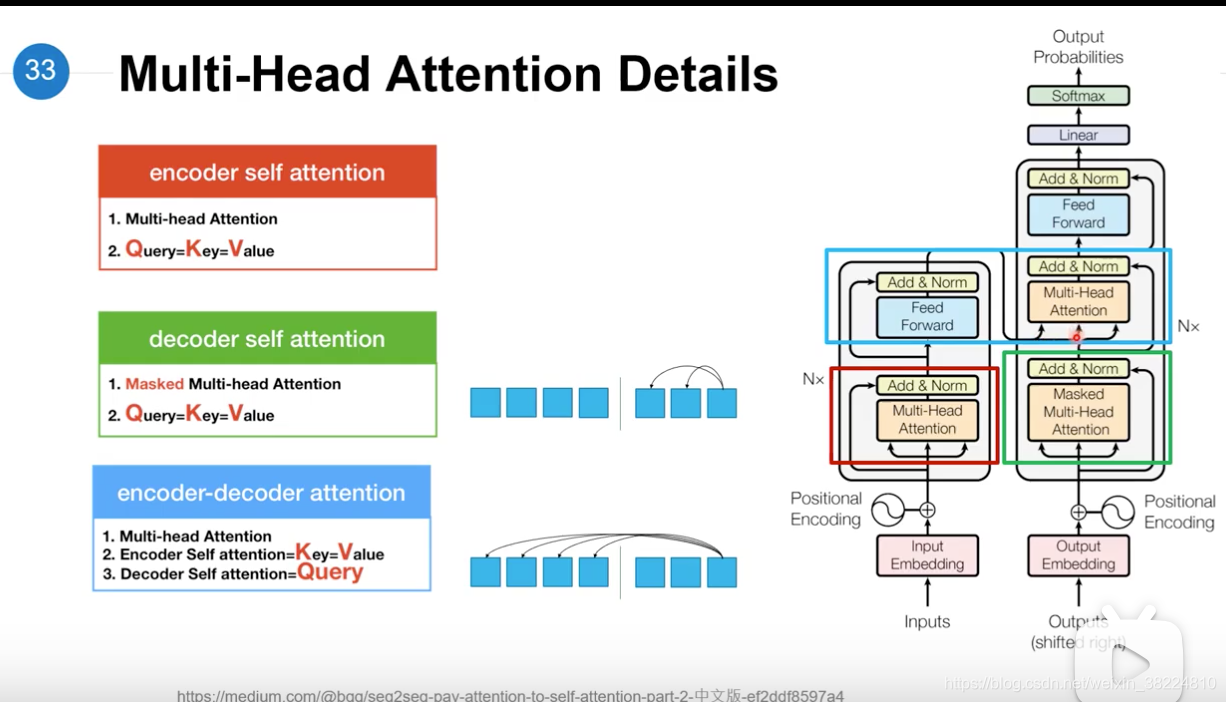

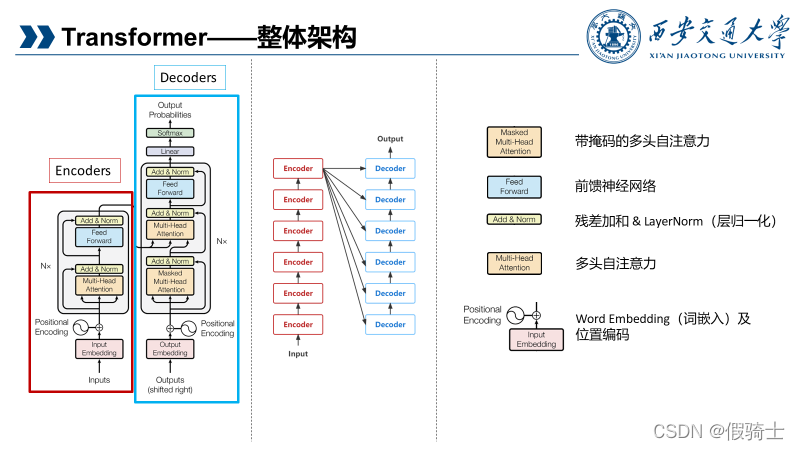

一切都得从 Transformer 说起Transformer 左半边为 Encoder,右半边为 Decoder我们将 Encoder 输入的句子称为 source,Decoder 输入的句子称为 target Encoder 负责将 source 进行 selfattention 并获得句子中每个词的 representation,最经典的 Encoder 架构就是 BERT,通过 Masked Language Model 来学习。

首先,让我们从模型的视角来区分encoder,就像一个魔术师,它将信息的宝藏转化为编码的密语,或者说是特征的提炼者它的任务是通过对输入数据进行复杂的处理,提取出关键特征,这些特征就如同数据的浓缩精华,为后续的分析和任务执行做好准备然后是decoder,它就像一个解码器,专门负责解读这些编码的。

Transformer模型中采用了 encoerdecoder 架构,论文中encoder层由6个encoder堆叠在一起,decoder层也一样每一层的encoder和decoder的结构如下图所示transformer模型中缺少一种解释输入序列中单词顺序的方法,它跟序列模型还不不一样为了处理这个问题,transformer给encoder层和decoder层的输入添加了一个。

大模型架构之争Transformer的Encoder与Decoder之差异解析 Transformer架构的崛起,已经超越了CNNRNNLSTM和GRU的传统界限,引发了深度学习领域的广泛关注如今,LLM领域正围绕encoderonlyencoderdecoder与decoderonly三种设计展开激烈的讨论BERT曾引领encoderonly的热潮,然而,T5和GPT系列,特别是GPT。